Bitcoin, często określany jako wirtualna złotówka przyszłości, zyskuje coraz większą popularność na rynku finansowym. Jego dynamiczny wzrost wartości w ostatnich latach prowadzi do debaty na temat jego trwałości i roli w globalnym systemie finansowym. Czy kryptowaluta ta jest rzeczywiście rewolucyjnym narzędziem przyszłości, czy może jest jedynie spekulacyjną bańką, która może pękając zdestabilizować globalne finanse? Zapraszamy … Read More „Bitcoin – Wirtualna złotówka przyszłości czy spekulacyjna bańka?” »

Wilgoć w murach to problem, który dotyka wielu właścicieli nieruchomości, prowadząc do poważnych problemów strukturalnych i zdrowotnych. Jednym z najbardziej efektywnych rozwiązań tego problemu jest iniekcja krystaliczna – innowacyjna metoda, która przemienia wilgotne ściany w suche, trwałe konstrukcje. Ta technika, wykorzystująca unikalne właściwości krystalicznych związków, pozwala na skuteczne zabezpieczenie budynków przed dalszym niszczeniem. Zapraszamy do … Read More „Iniekcja krystaliczna – skuteczna metoda osuszania murów” »

Przełom technologiczny na kołach przetacza się przez naszą rzeczywistość z niewiarygodną prędkością. Samochody elektryczne, niegdyś marzenie futurystów, dziś stają się codziennością. Ale czy zastanawialiście się kiedyś, jak działają samochody elektryczne? Zapraszamy do fascynującej podróży w głąb technologii, która zrewolucjonizowała świat motoryzacji. Budowa i zasada działania samochodów elektrycznych: od silnika do baterii Podstawowym elementem elektrycznej budowy … Read More „Przełom technologiczny na kołach – Tajemnice funkcjonowania samochodów elektrycznych odkryte” »

W świecie, gdzie granice pomiędzy rzeczywistością a wirtualną rozgrywką stają się coraz bardziej płynne, Discord wyłania się jako nowoczesna platforma komunikacji dla graczy. Co to Discord? To miejsce, które łączy graczy z całego świata, umożliwiając im dzielenie się doświadczeniami, strategiami i pasją do gier. W tym artykule zapoznasz się z każdym aspektem tej platformy, od … Read More „Discord – Nowoczesna Platforma Komunikacji dla Graczy – Wszystko, co Musisz Wiedzieć” »

W świecie, gdzie technologia stale pędzi naprzód, wybór idealnej karty graficznej może być zadaniem zniechęcającym. „Podążając za pikselami” to przewodnik, który pomoże Ci zrozumieć, jak wybrać kartę graficzną, która spełni Twoje wymagania. Przygotuj się na podróż przez labirynt specyfikacji, znamionującą drogę do niezwykłych wizualnych doświadczeń. Niezależnie od tego, czy jesteś graczem, twórcą zawartości, czy po … Read More „Podążając za pikselami – Przewodnik po wyborze idealnej karty graficznej” »

Czy kiedykolwiek zastanawiałeś się, co tak naprawdę kryje się pod maską twojego komputera? Jak wybrać procesor, aby był idealnym sprzymierzeńcem w codziennej pracy, grach, czy podczas twórczych zmaganiach z grafiką komputerową? Odkryj z nami sekrety procesorów, które stanowią serce każdego komputera, i dowiedz się, jak dokonać wyboru, który zrewolucjonizuje twoje doświadczenia technologiczne. Czym jest procesor … Read More „Pod maską komputera – Sekretny przewodnik po wyborze idealnego procesora” »

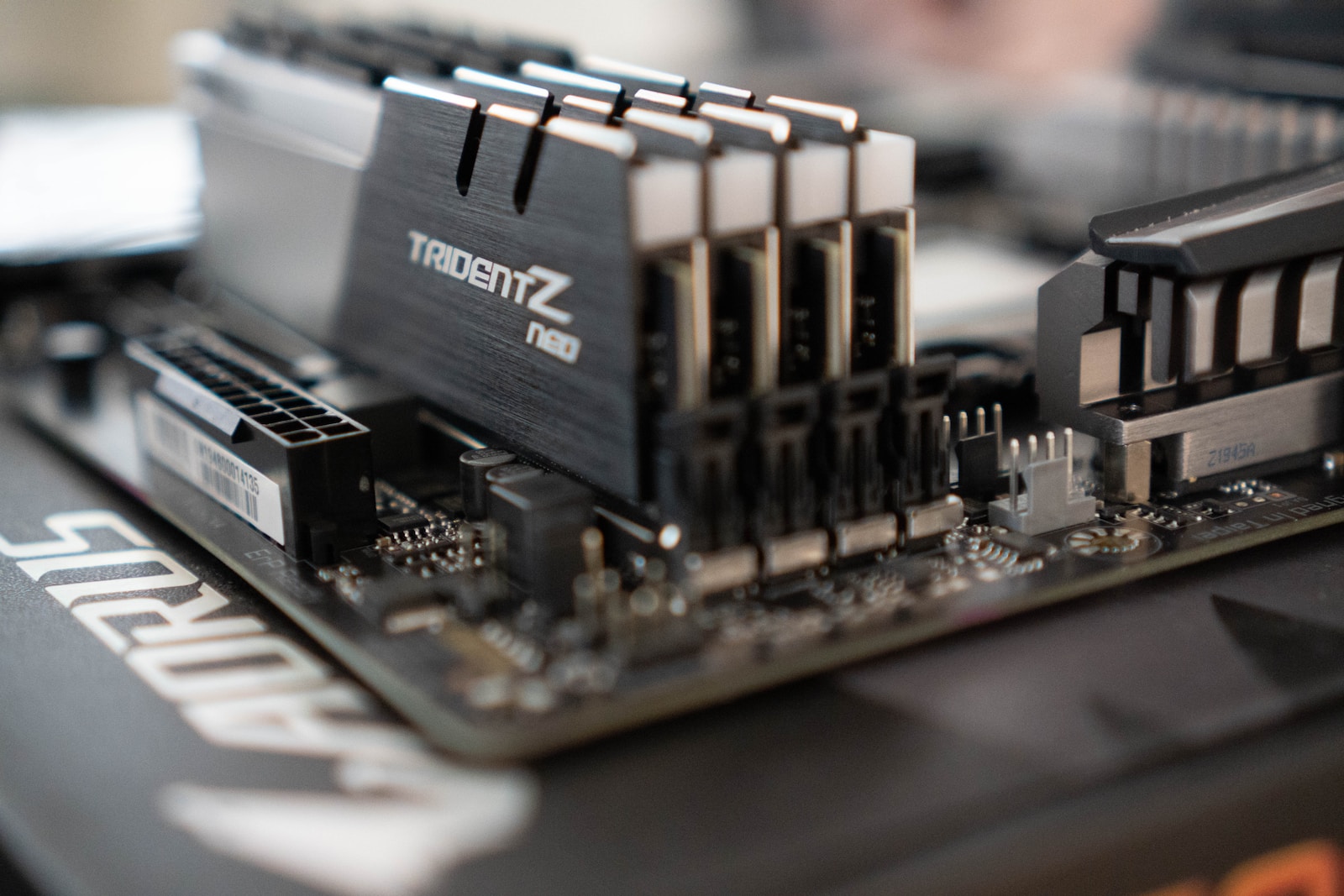

Decydując o składzie swojego komputera, często skupiamy się na procesorze czy karcie graficznej, zapominając o jednym z najważniejszych elementów – płycie głównej. To ona jest sercem naszej maszyny, łączącym wszystkie komponenty w spójną całość. Ale jak wybrać płytę główną, która będzie idealnie pasować do naszych potrzeb? Czytaj dalej, aby dowiedzieć się, na co zwrócić uwagę, … Read More „Decydujący Element Twego Komputera – Przewodnik po Wyborze Idealnej Płyty Głównej” »

Co to jest ultrabook? To nie tylko sprzęt, to przyszłość komputeryzacji, która już teraz mieści się w Twojej torbie. Ultrabooki to ultraportatywne cuda technologii, które przekraczają granice wydajności i mobilności, jakie znamy. Zanurzmy się w tajemnice tych kompaktowych, lecz potężnych maszyn, które przedefiniują nasze pojęcie o komputerach. Definicja i historia ultrabooków: od koncepcji do realizacji … Read More „Ultrabook – Komputer przyszłości w Twojej torbie – odkrywamy tajemnice ultraportatywnych cudów technologii” »

W erze cyfrowej mobilności, pytanie „Jaki router na kartę SIM?” staje się coraz bardziej relewantne. Przenośne, wydajne i niezawodne – te małe urządzenia mają moc zmienić sposób, w jaki łączymy się z siecią. W tym przewodniku zanurzamy się w technologię, aby pomóc Ci zrozumieć i wybrać router na kartę SIM, który najlepiej spełni Twoje potrzeby. … Read More „Przewodnik po najlepszych routerach na kartę SIM – Zrozum technologię, wybierz mądrze!” »

W upalne dni, nic nie przynosi ulgi jak dobrze działający wentylator. Ale z tak wielkim wyborem na rynku, jaki wentylator kupić, aby idealnie spełniał nasze oczekiwania? Czy szukasz cichego towarzysza do pracy, czy potężnej maszyny do chłodzenia całego pomieszczenia, ten poradnik pomoże Ci zrozumieć kluczowe cechy i funkcje, które powinieneś wziąć pod uwagę. Zanurzmy się … Read More „Jak wybrać wentylator? – Wybieramy Idealne ochłodzenie dla Twojego Domu” »